微软下一代 Maia 200 芯片性能将有大幅提升

CBINEWS

责任编辑:邹大斌

电脑商情在线

时间:2026-01-27 11:06

AI 芯片 TPU GPU 微软

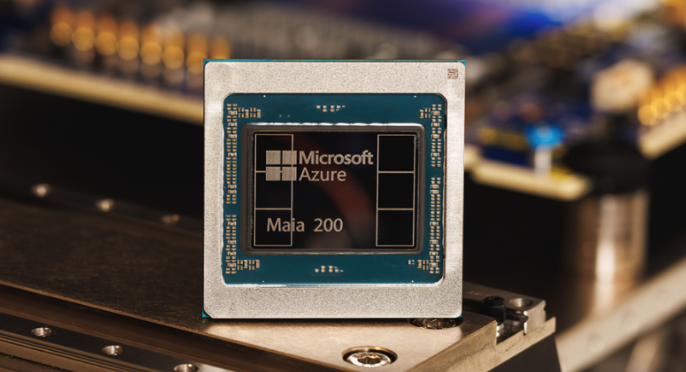

微软公司发布了其第二代自研人工智能处理器——Maia 200,宣称这是迄今为止任何公有云基础设施提供商所提供的最强大芯片。

该公司表示,在某些主流 AI 基准测试中,Maia 200 的计算性能达到亚马逊 AWS 最先进的 Trainium 处理器的三倍;在其他一些测试中,其表现也优于谷歌最新的张量处理单元(TPU)。

Maia 200 是 2023 年推出的 Maia 100 芯片的继任者,专为以更快速度和更高能效运行最先进的大语言模型而设计。该芯片集成超过 1000 亿个晶体管,可提供超过 10 petaflops(每秒千万亿次)的 4 位精度算力,并具备约 5 petaflops 的 8 位精度性能,相比初代自研芯片实现了显著提升。

微软表示,该芯片主要面向 AI 推理工作负载。推理是指运行已训练好的 AI 模型的过程。随着 AI 技术日益成熟,推理已成为 AI 运营成本中越来越重要的一部分。

据微软介绍,Maia 200 目前已在爱荷华州得梅因(Des Moines)的数据中心投入实际运行,支持包括 Copilot 365、OpenAI Group PBC 的 GPT-5.2 模型,以及其“AI 超级智能”(AI Superintelligence)团队的多个内部项目。公司计划在未来几周内,在凤凰城(Phoenix)的数据中心部署更多 Maia 200 芯片。

Maia 200 的发布进一步加速了大型云服务商开发自研 AI 处理器的趋势——这些芯片旨在替代英伟达的图形处理器(GPU)。尽管目前全球绝大多数 AI 工作负载仍由英伟达 GPU 处理,但其价格高昂且需求极为旺盛。这一趋势最早由谷歌近十年前推出的 TPU 引领,而亚马逊的 Trainium 芯片目前已进入第三代,第四代也即将推出。

相比之下,微软入局较晚,其首款 Maia 芯片直到 2023 年 Ignite 大会才正式亮相。尽管处于追赶阶段,微软表示,Maia 200 与 Copilot 等 AI 模型和应用的深度集成,使其在许多工作负载上具备优势。新一代芯片更专注于推理而非训练,这使其每美元的性价比比初代 Maia 芯片提升了约 30%。

由于各大云厂商为推进 AI 项目正消耗巨额资金,成本已成为关键的竞争差异点。虽然模型训练通常是一次性或周期性支出,但推理成本却是持续性的。因此,微软、谷歌和亚马逊都在努力降低推理成本,以挑战英伟达 GPU 的价格。

此外,微软还向第三方开发者开放支持,推出了一款新的软件开发工具包(SDK),帮助开发者针对 Maia 200 优化其 AI 模型。该 SDK 从今天起提供早期预览版。